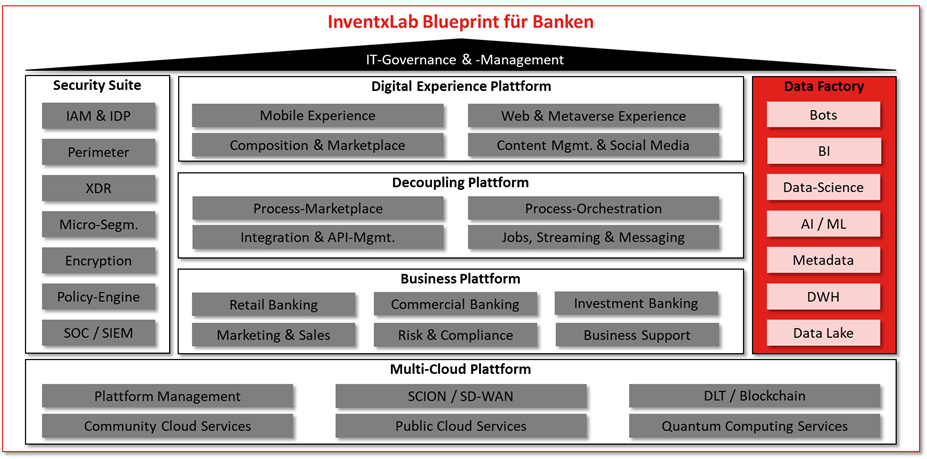

In unserem Blog vom 7. September 2023 haben wir einen high-level Orientierungsrahmen für die künftige Anwendungslandschaft in der Finanzindustrie geschaffen. Auf allen Plattform-Ebenen der Architektur ist viel Dynamik enthalten – so auch im Bereich der Data Factory, nachfolgend dargestellt am Beispiel Banking.

Traditionelle Lösungen

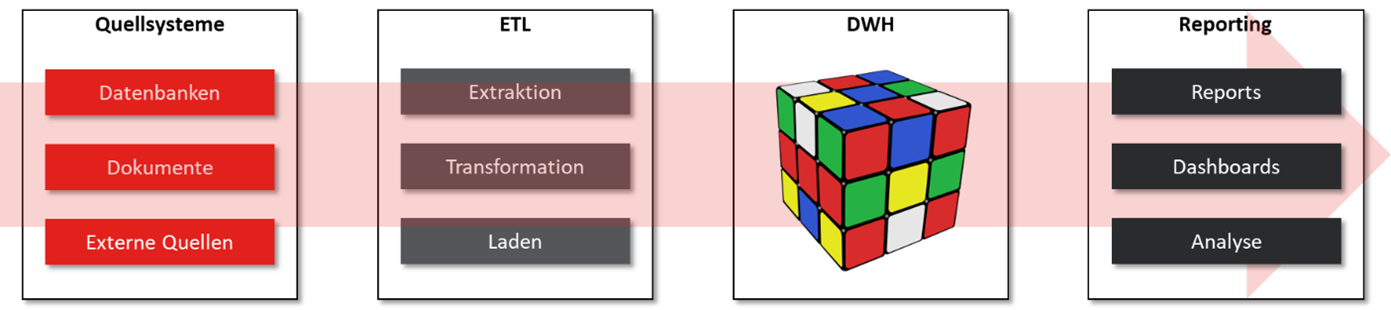

Die klassische Datenarchitektur besteht schon mehrere Jahre und ist in den Branchen Versicherung und Banking fest etabliert. Sie ist Data-Warehouse-zentriert aufgebaut, erfüllt primär das Bedürfnis nach Reporting und Analyse und wird wie folgt betrieben:

Dieses Konzept hat sich in den vergangenen Jahren zweifelsohne bewährt. Die Architektur ist jedoch in die Jahre gekommen und zahlreiche neue Business-Anforderungen sind entstanden. Daraus ergeben sich beachtliche Herausforderungen, die wir wie folgt zusammenfassen können:

- Mengen: Das kontinuierliche Datenwachstum sorgt dafür, dass die Systeme immer grösser und kostspieliger werden. Im damaligen Design waren die Systeme nur begrenzt auf diese Mengen ausgerichtet, was regelmässig zu Herausforderungen in der Lizenzierung oder Flexibilität der Infrastruktur führt.

- Performance: Die grossen Datenmengen sorgen dafür, dass die Durchlaufzeit in der Aktualisierung der Datenbestände an den Anschlag gerät. Bereits kleinere Störungen im Ladeprozess können einen ungewünschten Business Impact auslösen. Kommt hinzu, dass die Fachabteilungen mit möglichst aktuellen Daten arbeiten wollen.

- Analyse: Mit der fortschreitenden Digitalisierung und dem Einsatz neuer Technologien gibt es weitere unstrukturierte oder semistrukturierte Datenquellen, die für Realtime-Abfragen, Analysen und Reports genutzt werden wollen. Zum Beispiel Kundendokumente im PDF-Format aus einem digitalen Onboarding, Transkripte oder Stimmabdrücke etc.

- Komplexität: Die Anwendungslandschaft ist deutlich komplexer geworden und die Systeme verteilen sich auf verschiedene Cloud-Plattformen. Die Applikationslandschaften sind zwar noch immer dominiert vom Core-System, aber regelmässig werden Funktionen herausgelöst, dezentralisiert und entkoppelt. Dies führte zu einem regelrechten Dschungel an Ladejobs und grossen Abhängigkeiten.

- Verfügbarkeit: Die DWH- und Reporting-Systeme sind für das Daily Business im Verlauf der Jahre deutlich wichtiger geworden und müssen höchsten Anforderungen an Verfügbarkeit, Sicherheit und Resilienz gerecht werden.

- Innovationsfähigkeit: Mit Machine Learning und KI kommen neue Technologien auf, die im Business genutzt werden wollen. Solche Geschäftsprozess-Innovationen – wie zum Beispiel digitale Agenten – technisch umzusetzen, ist mit traditionellen Datenarchitekturen oft gar nicht möglich.

Betrachten wir nun die folgenden zwei Key-Konzepte einer modernen Datenarchitektur etwas genauer: DataLakeHouse und Data Mesh.

DataLakeHouse

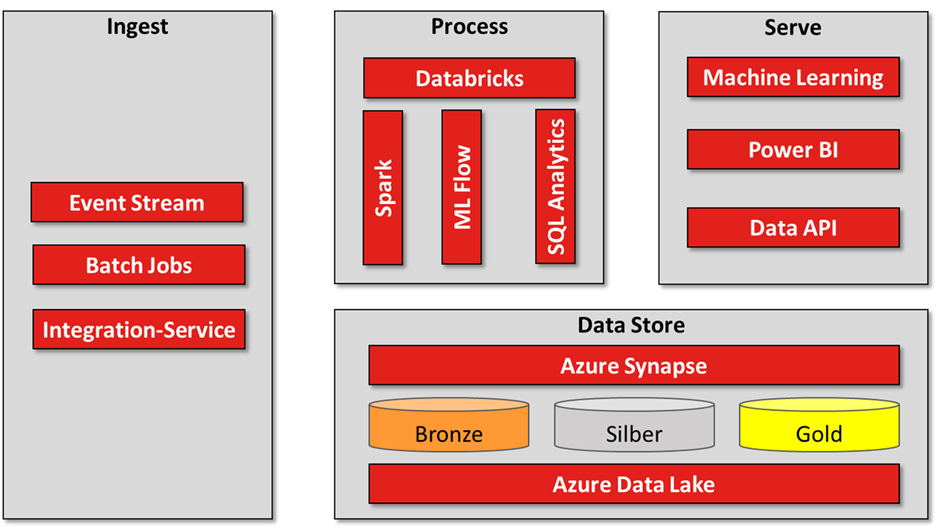

Dieses Konzept besteht aus der Symbiose von Data Lake und Data Warehouse. Das traditionelle Data Warehouse (1. Generation) beinhaltet strukturierte Daten (siehe Skizze oben), wohingegen ein Data Lake (2. Generation) einen Datenspeicher für Rohdaten resp. unstrukturierte (Massen-)Daten darstellt. Beide Konzepte basieren auf der zentralen Sammlung und Verwaltung der Daten. Das DataLakeHouse vereint demnach beide Konzepte mit dem Ziel, grosse Mengen an unstrukturierten und strukturierten Daten zentral bereitzustellen und zu nutzen. Die technologische Innovationsbasis wurde mit den Objektspeichern (S3-Storage, ab Ende der 90’er Jahre) und den OpenSource-Lösungen Apache Hadoop (2006) und Spark (2010 bzw. ab 2013 unter Apache) gelegt. Ein Objektspeicher ist im Vergleich zum Blockspeicher auf grosse Datenmengen und Skalierbarkeit ausgelegt – kann aber in Sachen Performance nicht mithalten. Apache Hadoop ermöglicht die Parallelisierung von Abfragen auf dezentralisierten Computer-Systemen (Cluster). Apache Spark nutzt In-Memory-Technologien (Caching) für die Optimierung und Beschleunigung von Abfragen auf grossen Datenmengen. Nachfolgend ein Beispiel auf Basis der Azure-Lösungen (in Anlehnung an Microsoft):

Die Segmentierung des Data Lakes mit Azure Databricks basiert auf dem so genannten Medaillon-Prinzip. Dieses Design-Pattern dient dazu, die Daten logisch zu gruppieren und entlang des Aufbereitungszyklus differenziert zu verwalten. Dabei umfasst die Stufe Bronze die Rohdaten, die Stufe Silber bereinigte, gefilterte oder erweiterte Daten und Gold die aggregierten Daten, die für den bestimmten Einsatzzweck genutzt werden.

Data Mesh

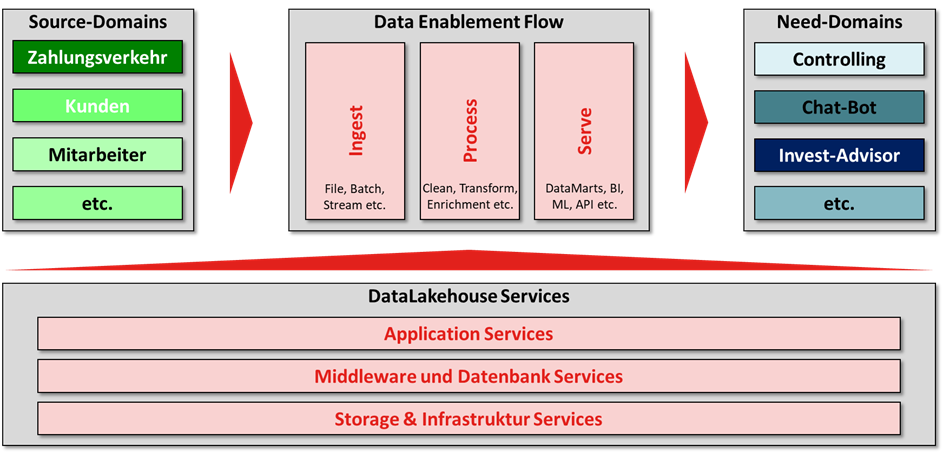

Der Begriff Data Mesh beschreibt die Daten-Governance (also organisatorisch-kulturelle Aspekte und keinen Technologie-Stack) in einem Unternehmen und wurde 2019 von der kalifornischen Technologieberaterin Zhamak Dehghani eingeführt. Sie beschreibt in ihrem Artikel den Paradigmenwechsel weg vom zentralisierten Datenmanagement hin zu einem dezentralen Ansatz auf Basis eines Lieferanten-Kunden-Verhältnisses, bei dem ein Domänen-Team seine Daten als Lieferant (Source-Domain) für andere Domänen-Teams (Kunden resp. Need-Domain) im Self-Service bereitstellt.

Der Ansatz beruht einerseits darauf, dass Daten kein Abfallprodukt von Business-Anwendungen, sondern wertvolle Assets sind. Andererseits etablierte sich in der Informatik der Produkt-Gedanke (z.B. entlang von Geschäftsbereichen resp. Domänen oder Wertströmen) und die IT-Abteilungen organisierten sich entsprechend neu und übernahmen die DevSecOps-Verantwortung über den gesamten Lifecycle der zugeordneten IT-Lösungen. Jede Applikation hat demnach nicht nur die gewünschte Funktionalität zu liefern, sondern auch den Datenoutput bereitzustellen.

Fazit: Es braucht für eine Data-driven Business-Strategie eine Datenplattform der dritten Generation

Unter DataLakeHouse verstehen wir daher die Architektur einer modernen Datenplattform, die strukturierte und unstrukturierte Daten umfasst. Data Mesh ist ein primär organisatorisches Konzept, das die Governance von dezentralisierten Daten der dazugehörenden Applikationen behandelt. Datenprodukte werden dabei analog einer Business-Funktion als integraler Bestandteil einer Anwendung bzw. Domäne verstanden. Da das Ziel vor Augen steht, auf Basis von Geschäftsdaten einen Mehrwert im Geschäftsmodell für interne und externe Kunden zu generieren, schwenken viele Unternehmen auf einen datengetriebenen Ansatz um. Eine Data-driven Business-Strategie erfordert die Transformation auf eine moderne Daten-Plattform (3. Generation). Dabei müssen tiefgreifende technische und organisatorische Änderungen erfolgen. Das Zielbild kann vereinfacht wie folgt dargestellt werden:

Zusammenfassend können folgende Key-Prinzipien für die moderne Datenarchitektur abgeleitet werden:

- Dezentralisierung: Daten sind als Produkt zu verstehen und in einer dezentralen Organisation entlang von Domänen mit einer definierten Governance auszugestalten.

- Produktorientierung: Ein Domain-Team muss handlungsfähig sein und besteht folglich u.a. aus System-Engineers, Software-Engineers UND Daten-Engineers. Das «Datenprodukt» ist integraler Bestandteil des funktionalen und nicht-funktionalen Anforderungssets.

- Real-Time: Dafür braucht es Streaming-Lösungen (Kafka, seit 2012 unter Apache) in Kombination mit moderner Batch-Job-Verwaltung (z.B. Apache Beam, 2016).

- Kundenzentrierung: Die Daten müssen den (internen) Kunden resp. Bedarfssystemen über standardisierte Schnittstellen und als Self-Service bereitgestellt werden.

- Cloud-First: Dank skalierbarer Leistungen aus der Hybrid-Cloud wie z.B. dem S3-Storage der Cloud, Azure Blob, Synapse oder Databricks als Service kann die eigene Organisation businessnahe und differenzierende Leistungen erbringen.

Die Schweizer Finanzindustrie steckt mitten in der «Data-driven Business»-Transformation. Diese grundlegende Veränderung bedingt die technische und organisatorische Umstellung auf moderne Lösungen und Betriebsmodelle. Aus Daten werden Informationen und aus Informationen müssen Insights gewonnen werden.

Wo steht Ihre Transformation der Daten-Architektur? Wir freuen uns auf Ihre Kontaktaufnahme.