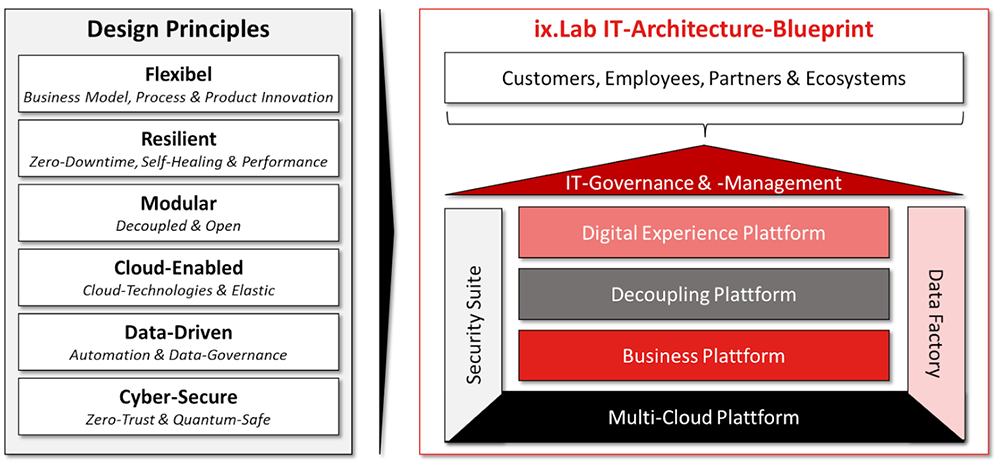

Die Dynamik wird weiterhin zunehmen und IT-Investitionen sollen reflektiert und zielorientiert sein. Wir haben uns deshalb zuerst gefragt, welches die kritischen Trigger der Veränderung der IT-Architektur sind. Diese haben wir in den „Design Principles“ zusammengefasst und dann ein standardisiertes, high-level Architektur-Modell geschaffen. Dieser modellartige IT-Architektur-Blueprint soll eine logische Grundstruktur für die Transformation schaffen und Funktionen zu logischen Clustern (Plattformen) bündeln – bewusst noch ohne vertikale Differenzierung.

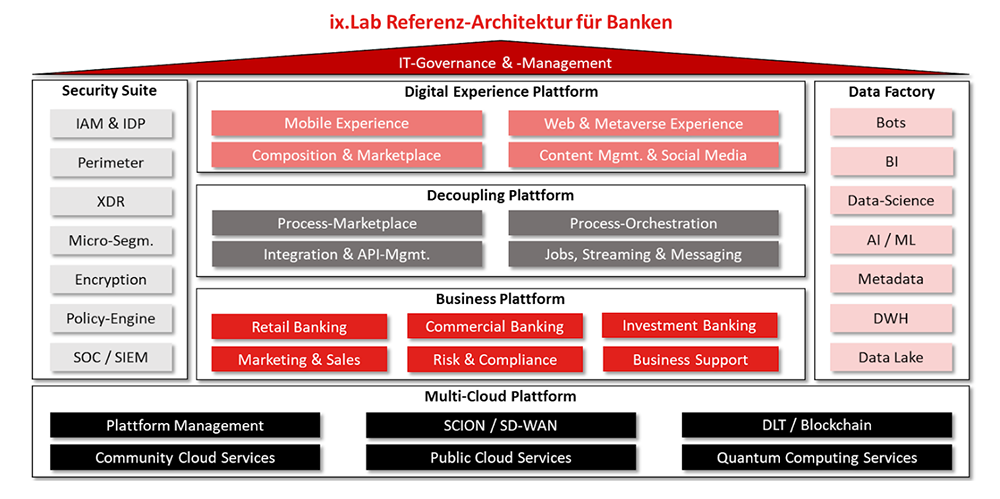

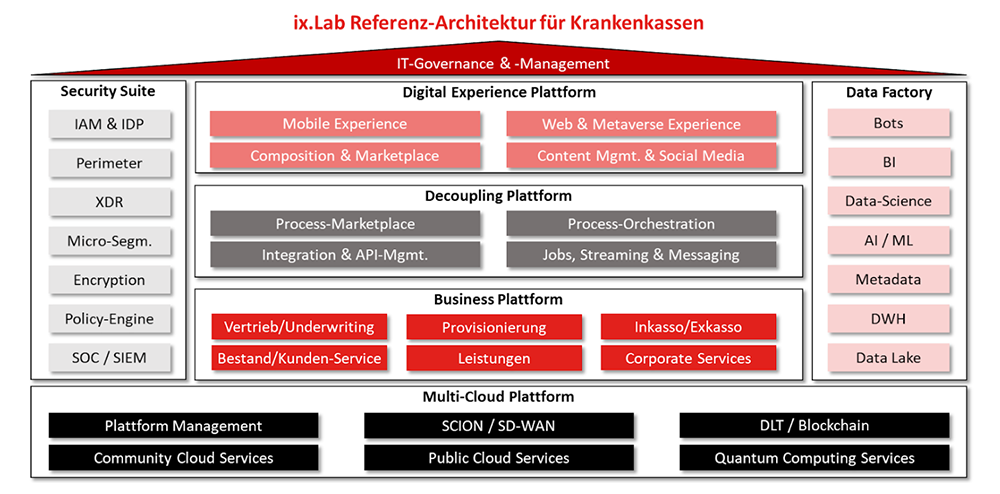

Mit diesem plattformorientierten Basis-Modell haben wir danach die Anwendungslandschaften in den Ausprägungen „Bank“ und „Krankenversicherung“ im Zielbild definiert, wobei sich die Vertikalisierung in der „Business Plattform“ zeigt. Auf die branchenspezifischen Unterschiede in der „Digital Experience Plattform“ sind wir auf dieser Abstraktionsebene bewusst nicht eingegangen, da die Kanäle durchaus vergleichbar sind.

Fassen wir nun die wichtigsten Funktionen pro Cluster kurz zusammen:

(1) Multi-Cloud-Plattform

Die künftige Infrastruktur-Plattform (IaaS/PaaS) besteht einerseits aus Community-Cloud und Public-Cloud Services aber auch aus den aufstrebenden Technologien Quantum Computing und Blockchain. Diese Plattformen sorgen dafür, dass alle Workloads die optimalen Betriebsbedingungen vorfinden, ganz egal ob CPU, GPU, Quantum oder DLT. Weiter gilt es die sichere und performante Inter-Konnektivität (WAN) der dezentralen Cloud-Plattformen sicherzustellen, das Schutzlevel zu erhöhen und die Plattform in die erforderlichen Desaster-Recovery-Zonen zu strukturieren. Die Microsegmentierung (Cloud-LAN) – obwohl per Definition Teil des IaaS-Stack – führen wir im Bereich der Security-Suite, da für uns nicht das Netzsegment per se, sondern die Kontrolle der Kommunikation zentral ist.

(2) Business Plattform

Die Business Plattform bildet die Geschäftsmodelle sowie die Geschäftsprozesse des Unternehmens ab. Aktuelles Herzstück dieser Gruppe bildet das Kernsystem (z.B. Finnova, Avaloq oder Syrius), wobei dieses mit diversen Umsystemen ergänzt wird. Umsysteme können vertikalen Charakter aufweisen (z.B. Zahlungsverkehr, Leistungsabrechnung) oder branchenneutral/horizontal sein (z.B. Dokumentenarchiv). Die monolithischen Strukturen der heutigen Kernanwendung werden noch weiter aufgebrochen und die Funktionalität und die Datenhaltung dadurch zunehmend dezentralisiert.

(3) Decoupling Plattform

Der Decoupling-Plattform kommt eine zentrale Rolle in der Integrationsarchitektur zu. Hier werden die einzelnen (internen und externen) Services orchestriert und die Anwendungen auf Basis von Standardschnittstellen (API-first) integriert und sicher gegen aussen geöffnet (Open-/Embedded-Finance). Weiter wird der Datentransfer zwischen den Anwendungen gesteuert resp. die Konsistenz der dezentralen Datenhaltung sichergestellt. Dies ist ein zentraler Paradigma-Wechsel im Vergleich zur heutigen „Golden Record“ Architektur.

(4) Security Suite

In der Security werden die IT-Sicherheitsfunktionen über alle Service-Modelle (IaaS/PaaS/SaaS) auf Basis des Zero-Trust-Konzepts zentral verwaltet. Dem Access-Management kommt dabei eine zentrale Rolle (RBAC, PAM etc.) und faktisch der gleiche Stellenwert wie dem klassischen Perimeter (Firewall, WAF, Proxies etc.) zu. Die IT-Security-Konfiguration soll dabei auf Basis der definierten Policies als Code verwaltet und auf die Systeme in der Multi-Cloud angewendet werden. Die Logs aller Endpoints (Clients, Server, Anlagen) werden in einem Security-Data-Lake gesammelt und auf Anomalien geprüft, wobei die Anwendung von künstlicher Intelligenz (AI) und die risikobasierte Ausgestaltung von Detection-Use-Cases besonders hervorzuheben sind. Im Weiteren gilt es, die aktuelle Verschlüsselung auf quantensichere Standards (Quantum Safe Encryption) zu transformieren (siehe ix.Lab Blog vom 26.5.2023).

(5) Data Factory

Dem dezentralen Daten-Management und der systematischen Nutzung von Geschäftsdaten in Kombination mit externen Daten kommt eine strategische Rolle zu. Um Bots, AI-Anwendungen (z.B. FraudDetection) und Machine-Learning Funktionen optimal zu nutzen, gilt es Daten im Data Lake zu sammeln, allenfalls anzureichern (Data-Pipelines) um sie dann den Anwendungen in der richtigen Qualität, Struktur und möglichst real-time zur Verfügung zu stellen. Die Regeln der Daten-Interpretation (Metadaten) sorgen für die automatisierte und sichere Verarbeitung der Daten. Die Berechtigungen für den Datenzugriff werden durch die Security-Suite sichergestellt.

Ziel ist es, mit diesen Referenz-Architekturen eine praktische Hilfestellung und Diskussionsbasis für die Weiterentwicklung der Informatik in den Branchen Banking und Insurance zur Verfügung zu stellen.

Gerne nehmen wir Anregungen auf, stehen zur Verfügung und freuen uns über Feedback.